處理海量資料一定要用Hadoop?開放原始碼專家想出更簡單的解決方案!

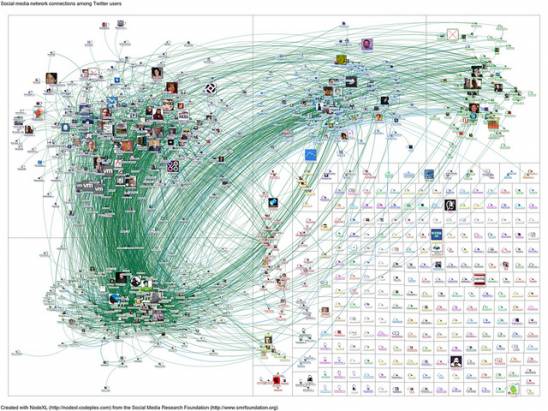

Google強大的搜尋引擎每天處理龐大的搜尋數據,靠的是數十萬的伺服器同時作工。然而一般企業並無法使用Google所用的內部搜尋引擎工具,所以,擁有處理巨量數據工具的分散式運算平台Hadoop應運而生。

但問題是Hadoop使用上有難度,數據處理公司Cloudera決心要解決這個問題。

過去的公司企業仰賴傳統的關聯式資料庫和數據倉儲就可應付所需,然而,今日電子商務、社交媒體和行動運算不斷成長使得資料量暴增,許多企業便開始使用Hadoop等的工具處理數據。現在,Cloudera現在更針對Hadoop平台推出類Google的搜尋引擎:Cloudera Search。

搜尋引擎讓Hadoop更平易近人

Cloudera希望客戶能在Hadoop壯大之前就將資料儲存進去,並將之整合入平台。但使用Hadoop平台與資料互動必須要懂得MapReduce運算技術,也就是說你得會寫Java語言,這對許多使用者來說並不方便。

雖然Hadoop已經推出許多工具讓使用上更便利,但Cloudera希望更進一步建立一個Hadoop的搜尋引擎。產品經理澤德勒維斯基(Charles Zedlewski)說:「數萬開發者可能知道怎麼用MapReduce,執行SQL指令,但會使用搜尋引擎的人有數十億人。」

Cloudera Search能夠與Hadoop分散式檔案系統(HDFS)或資料庫系統Hbase整合,使用者可以輸入搜尋字串後就找到一串搜尋結果。這項搜尋工具是以Apache Solr搜尋器為基礎。

市場研究公司RedMonk分析師歐葛瑞迪(Stephen O’Grady)表示:「每多一項數據處理工具對Hadoop都有好處……從寫MapReduce程式到支援SQL語法的Hive或Pig等套件,每項工具都讓數據處理更有效率。」

所有大數據都該放入Hadoop嗎?

這對改善Hadoop可用性的確幫助不少,但問題是:客戶是否真的有需要將它們所有的數據都放入Hadoop?微軟今年稍早發表一份報告,主張大多數的公司只需要增加叢集伺服器的使用數量,不須嘗試用單台伺服器處理數據,報告指出,甚至雅虎和臉書兩家最需要數據處理效能的公司,也是透過增加伺服器叢集解決效能問題。

但許多公司正面臨數據不斷增長的問題,一開始就加入Hadoop是不錯的選擇,RedMonk過去也是Hadoop的使用者,但最近轉用BigQuery等其他的Google資料庫工具,原因是他們的數據在量上本質就比較小,而且成長的速度也沒有分析師原本預測得快。

但歐葛瑞迪說:「如果我們能夠更快速地獲得數據,就一定會使用Hadoop!」

推薦閱讀: